Mostrando del 21 al 30 de 2.716 coincidencias

Se ha buscado por el tag: n

********************************************************************************************************************

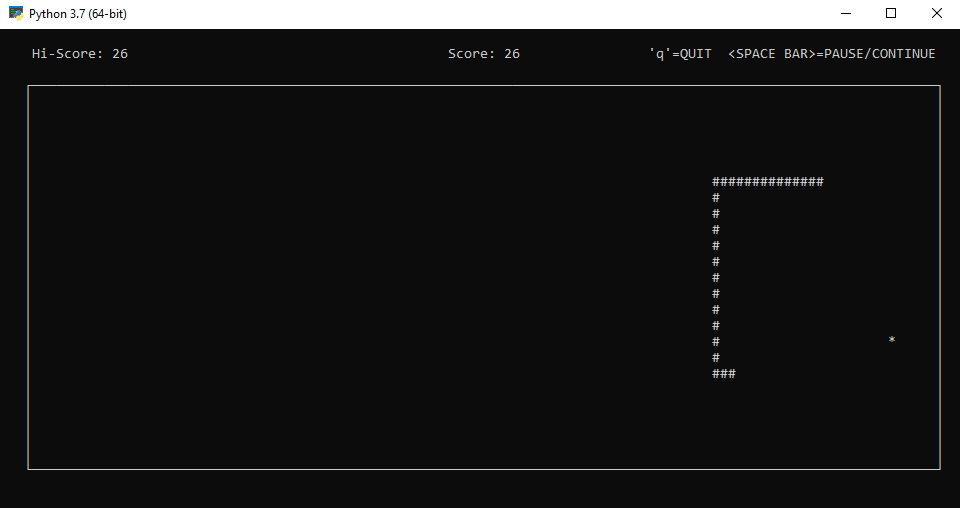

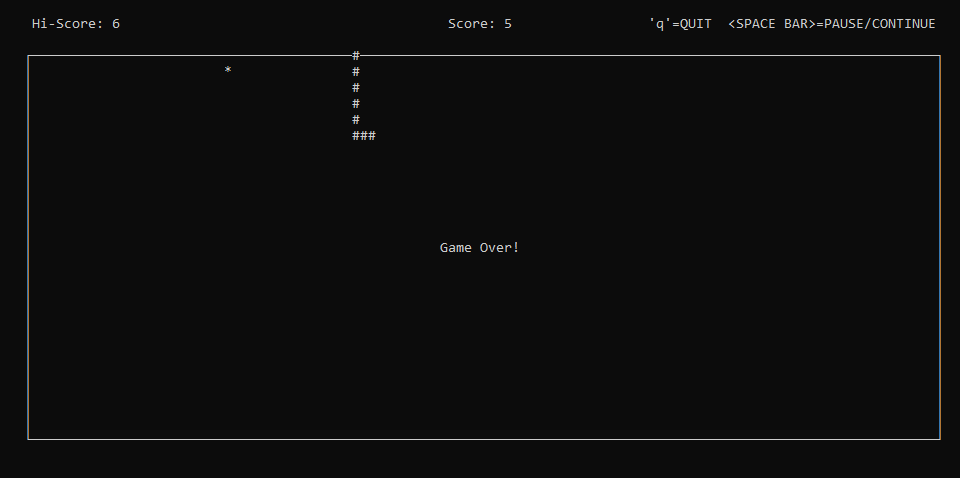

Propongo el ejercicio:

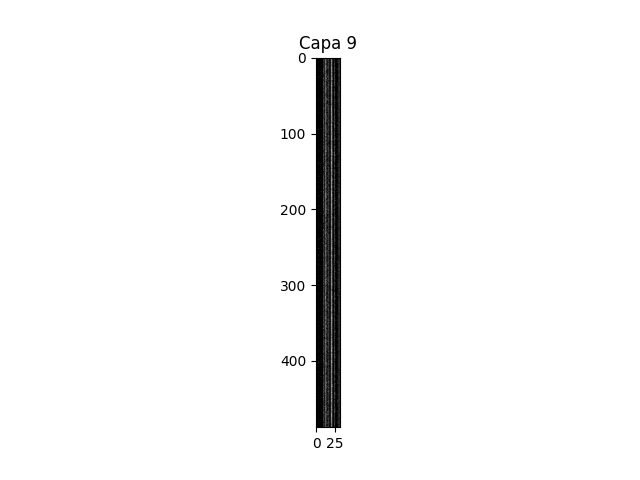

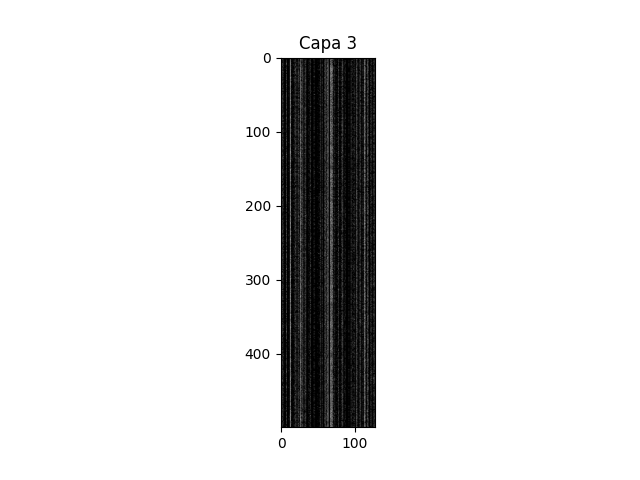

Aula_18_Feb_24.py, realizado en python. En el mismo trato de formular una red convolucional, lo más sencilla posible, con el fin ver el desarrollo de nueve capas convolucionales. Tratando de indagar y visualizar la salida después de cada capa utilizando un bucle. Por cada salto de bucle iremos viendo los valores correspondientes de la activación, al mismo tiempo que visualizaremos el resultado de la imagen, que será un tanto incongruente ya que sólo se trata de ver su funcionamiento.

A continuación describo las particularidades de este corto código:

*************************************************************************

Como se aprecia en las llamadas iniciales de importación de módulos, utiliza TensorFlow y Keras para crear un modelo de red neuronal convolucional (CNN) y visualiza las salidas de cada capa convolucional para una imagen de entrada aleatoria. Aquí está la descripción del código:

Importar bibliotecas:

------------------------------

numpy: Para trabajar con matrices y generar imágenes aleatorias.

matplotlib.pyplot: Para visualizar las salidas de cada capa convolucional.

tensorflow.keras.models.Sequential y tensorflow.keras.layers.Conv2D: Para construir la arquitectura del modelo CNN.

Crear el modelo:

---------------------

Se crea un modelo secuencial (Sequential) que representa la arquitectura de la red.

Agregar capas convolucionales:

------------------------------------------------

Se agregan varias capas convolucionales al modelo con diferentes números de filtros y funciones de activación

ReLU.

Obtener las salidas de cada capa convolucional:

-----------------------------------------------------------------------

Se crea un modelo de visualización (visualization_model) que toma la entrada del modelo original y produce las salidas de cada capa convolucional.

Generar una imagen de entrada aleatoria:

-----------------------------------------------------------

Se crea una imagen de entrada ficticia con dimensiones (1, 600, 506, 3).

Si se quiere se podría hacer con carácter fijo en vez de aleatorio.

Obtener las activaciones de cada capa:

--------------------------------------------------------

Se obtienen las activaciones de cada capa convolucional para la imagen de entrada utilizando el modelo de visualización.

Visualizar las salidas de cada capa:

----------------------------------------------

Se itera sobre las activaciones y se muestra la salida de cada capa convolucional. Si la salida tiene cuatro dimensiones, se aplanan y visualizan las activaciones en escala de grises.

Como indiqué, este código es útil para entender cómo evoluciona la representación de la imagen a medida que pasa a través de las capas convolucionales de la red. Cada visualización muestra las activaciones de una capa particular, lo que puede ayudar a interpretar cómo la red extrae características en diferentes niveles de abstracción.

******************************************************************************************************************

Este código fue realizado bajo plataforma linux, con

Ubuntu 20.04.6 LTS.

Fue editado con

Sublime text.

Se deberá tener en cuenta que el sistema tendrá que tener cargado para las importaciones

los siguientes módulos:

import

numpy as np

import

matplotlib.pyplot as plt

from t

ensorflow.keras.models import Sequential, Model

from tensorflow.keras.layers import Conv2D

La Versión de Python en mi ordenador es:

Python 3.8.10.

****************************************************************************************

#

Ejecución:python3 Aula_18_Feb_24.py

********************************************************************************************************************

En este breve ejercicio, pretendo explicar algunas dudas sobre la utilizacion de

ImageDataGenerator.

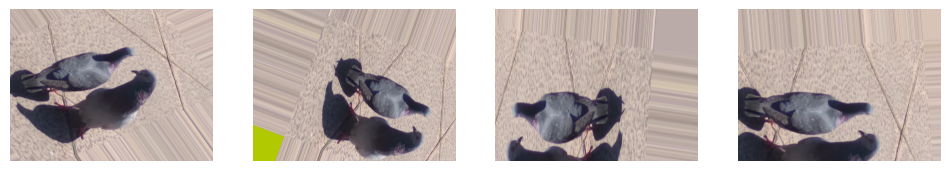

Esta función se utiliza en las redes convolucionales, para nodificar los parámetros o apariencia de las imagenes

utilizadas para el training, con el propósito principal de mejorar el rendimiento y la generalización del modelo mediante el aumento de datos y la normalización.

Aquí están los objetivos clave:

--------------------------------------

Aumento de Datos para Mejor Generalización:

El aumento de datos implica aplicar transformaciones aleatorias a las imágenes durante el entrenamiento, como rotación, cambio de escala, volteo horizontal, etc. Este proceso aumenta la diversidad del conjunto de datos, permitiendo que el modelo vea variaciones de las imágenes originales. Como resultado, la CNN se vuelve más robusta y generaliza mejor a nuevas imágenes que puede encontrar durante la inferencia.

Prevención de Sobreajuste (Overfitting):

El sobreajuste ocurre cuando un modelo aprende demasiado bien los detalles específicos del conjunto de entrenamiento y tiene dificultades para generalizar a datos no vistos. El aumento de datos ayuda a prevenir el sobreajuste al introducir variaciones artificiales en las imágenes de entrenamiento. Esto es crucial cuando el conjunto de datos es relativamente pequeño.

Normalización para Facilitar el Entrenamiento:

La normalización de píxeles (escalando valores a un rango específico, como [0, 1]) facilita el proceso de entrenamiento. Al tener valores de píxeles en un rango más pequeño, los gradientes durante el entrenamiento son más estables, lo que puede llevar a una convergencia más rápida del modelo.

Manejo Eficiente de Grandes Conjuntos de Datos:

Cuando trabajas con grandes conjuntos de datos que no caben completamente en la memoria, ImageDataGenerator permite cargar y procesar las imágenes de manera eficiente en lotes durante el entrenamiento. Esto es esencial para hacer frente a conjuntos de datos de tamaño considerable.

En resumen, ImageDataGenerator contribuye significativamente a mejorar la capacidad de generalización de una CNN, a hacer que el modelo sea más robusto frente a variaciones en los datos y a facilitar el proceso de entrenamiento, especialmente cuando se trata de conjuntos de datos grandes.

********************************************************************************************************************

Un ejemplo típico de argumentos pasados a ImageDataGenerator sería el siguiente:

datagen = ImageDataGenerator(

rescale=1./255, # Normalización

rotation_range=20, # Rango de rotación aleatoria

width_shift_range=0.2, # Rango de cambio horizontal aleatorio

height_shift_range=0.2, # Rango de cambio vertical aleatorio

shear_range=0.2, # Rango de cizallamiento aleatorio

zoom_range=0.2, # Rango de zoom aleatorio

horizontal_flip=True # Volteo horizontal aleatorio

)

********************************************************************************************************************

********************************************************************************************************************

Este programa ha sido editado y ejecutadoi con Google Colab.

El archivo de jemplo estaba alojado en Drive de Google Colab.

---------------------------------------------------------------------------------------------------------------------------

Sencillo_Concep_Pixel_Aula_28.py

**********************

********************************************************************************************************************

Con este sencillo y diminuto ejercicio, tratamos de explicar algunas dudas conceptuales sobre el tratamiento y comprensión

del funcionamiento de los pixeles.

Aula 28.

-----------------------------------------------------------------------------------------------------------------------

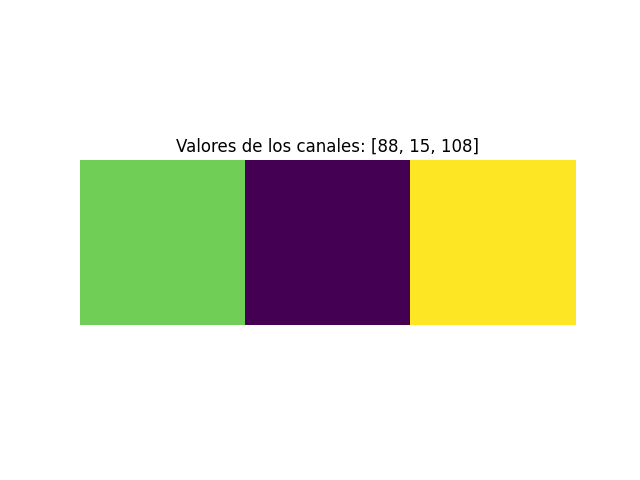

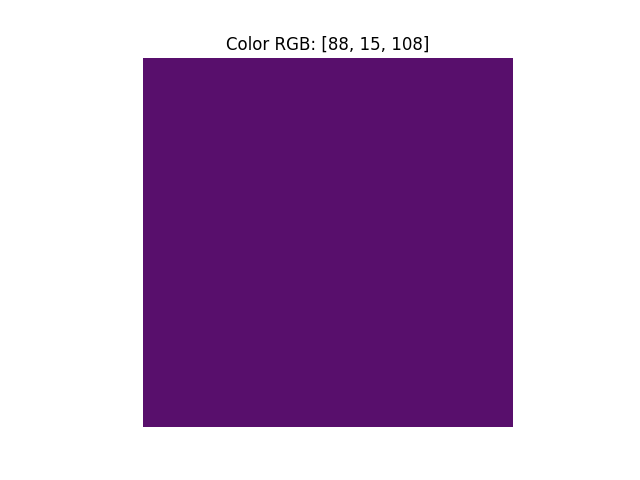

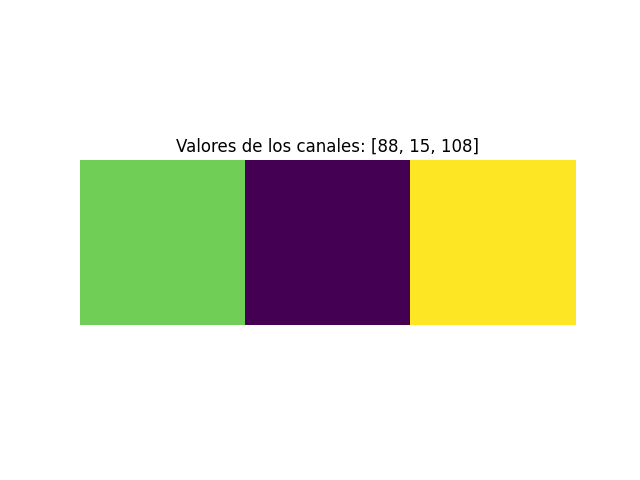

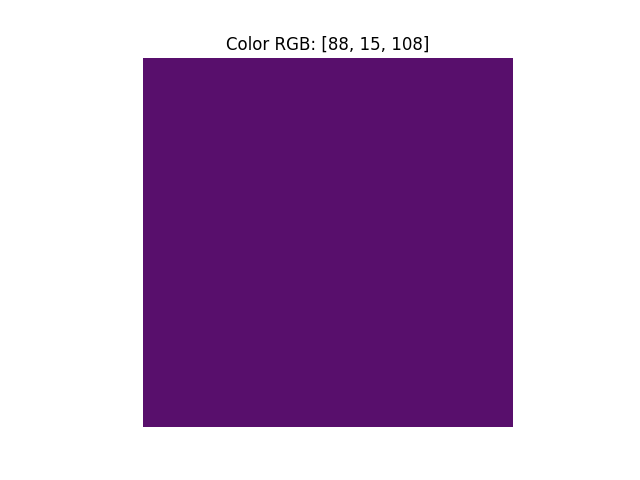

Definición de los valores del píxel:

------------------------------------------------

Se especifican los valores de los canales rojo, verde y azul del píxel. En este caso, son [88, 15, 108].

Visualización de la imagen sin normalización:

---------------------------------------------------------------

Se crea una imagen de 1x1 píxeles con los valores de los canales y se muestra directamente. La escala de colores refleja los valores originales sin ajustes.

Normalización de los valores de los canales:

--------------------------------------------------------------

Se normalizan los valores de los canales dividiéndolos por 255.0. Este paso es común en procesamiento de imágenes para asegurarse de que los valores estén en el rango [0, 1].

Visualización de la imagen normalizada:

--------------------------------------------------------

Se crea una nueva imagen con los valores normalizados y se muestra. La escala de colores ahora refleja los valores ajustados al rango [0, 1].

Impresión de la matriz normalizada:

--------------------------------------------------

La matriz normalizada se imprime en la consola. Esto muestra cómo los valores de los canales se han ajustado a la escala [0, 1].

En resumen, el código realiza dos visualizaciones de un píxel: una con los valores de los canales originales y otra después de normalizar esos valores para asegurarse de que estén en un rango comprensible para la visualización de colores.

Salida por consola de los pixels normalizados.

[[0.34509804 0.05882353 0.42352941]]

***********************************************************************************************

Realizado en Plataforma Linux. Ubuntu 20.04.6 LTS

Editado con Sublime text.

Ejecución:python3 Sencillo_Concep_Pixel_Aula_28.py

************************************************************************************************

Con este ejemplo sencillo, pretendo explicar como realizar un ejercicio llamado: Crear_Modelo_CN_Aula-28.py, para entrenar una red neuronal convolucional (CNN), siguiendo varios pasos. Aquí te proporcionaré un resumen general de los pasos que puedes seguir utilizando bibliotecas como TensorFlow y Keras en Python. Ten en cuenta que esto es solo una guía básica, y dependiendo de tus necesidades específicas, es posible que debas ajustar algunos parámetros y configuraciones, incluso incrementar la dificultad del ejercicio.

Paso 1: Preparar tus datos.

--------------------------

Organizar tus datos:

Divide tus datos en conjuntos de entrenamiento y prueba. El conjunto de entrenamiento se utiliza para entrenar el modelo, mientras que el conjunto de prueba se utiliza para evaluar su rendimiento.

Asegúrate de tener etiquetas asociadas a cada imagen para supervisar el entrenamiento.

Preprocesamiento de imágenes:

----------------------------

Normaliza las imágenes (escala los valores de píxeles entre 0 y 1).

Redimensiona las imágenes según los requisitos de entrada de tu red neuronal.

Paso 2: Crear la arquitectura de la CNN.

---------------------------------------

Importar bibliotecas:

Importa TensorFlow y Keras.

Definir el modelo:

Crea un modelo secuencial (Sequential) o funcional de Keras.

-----------------------------------------------------------

Agrega capas convolucionales, capas de agrupación (pooling), y capas totalmente conectadas según tu arquitectura.

Paso 3: Compilar el modelo.

--------------------------

Compilar el modelo:

Especifica la función de pérdida, el optimizador y las métricas que se utilizarán para evaluar el rendimiento del modelo.

Utiliza el método compile de Keras.

Paso 4: Entrenar el modelo.

--------------------------

Entrenar el modelo:

Utiliza el método fit de Keras.

Proporciona el conjunto de entrenamiento y valida con el conjunto de prueba.

Ajusta el número de épocas y el tamaño del lote según sea necesario.

Paso 5: Evaluar el modelo.

-------------------------

Evaluar el modelo:

Utiliza el conjunto de prueba para evaluar el rendimiento del modelo.

Puedes usar el método evaluate de Keras.

Paso 6: Guardar el modelo entrenado.

----------------------------------

Guardar el modelo:

Utiliza la función save de Keras para guardar el modelo entrenado en un archivo.

PRESENTACION DE LAS IMAGENES DE ENTRENAMIENTO.

********************************************

Básicamente estamos hablando de dos formas:

[indent]CASO_1

*****

Imaginate que tengo estas imagenes:

imagen_1.jpg

imagen_2.jpg

imagen_3.jpg

imagen_4.jpg

imagen_5.jpg

imagen_6.jpg

imagen_7.jpg

imagen_8.jpg

.....

imagen_121.jpg

imagen_122.jpg

imagen_123.jpg

imagen_124.jpg

[/indent]

*************************************************************************************

Sí, en tu caso, no hay clases específicas y solo tienes un conjunto de imágenes numeradas, simplemente colocarlas en orden jerárquico dentro del directorio de entrenamiento (train) es suficiente. La estructura que te proporciono como ejemplo refleja esa simplicidad.

Esta podría ser una ruta normal de archivos, al que llamamos en el directorio principal: ProyectoCNN

[indent]ProyectoCNN/

└── dataset/

└── train/

├── imagen_1.jpg

├── imagen_2.jpg

├── imagen_3.jpg

├── imagen_4.jpg

├── imagen_5.jpg

├── imagen_6.jpg

├── imagen_7.jpg

├── imagen_8.jpg

├── ...

└── imagen_124.jpg

[/indent]

----------------------------------------------------------------------------------------------------------------

----------------------------------------------------------------------------------------------------------------

CASO_2.

*********

En nuestro ejemplo utilizaremos, este formato de almacenamiento (CASO_2.), para entrenar el modelo.

Bien, imaginate ahora que tenemos estos directorios de clase:

(En mi caso, con el fin de coger el concepto de su funcionamiento solo he aportado 3 imagenes para cada tipo. Por lo

que los resultados de la predicción son bastante pobre, para aumentar la eficacia debería hacerse con miles de imagenes. Ten en cuenta que habitualmente para train, los modelos ya entrenados que descargamos pueden rondar las 60.000 imagenes.)

[[indent]b]camiones:

--------

imagen_1.jpg

imagen_2.jpg

imagen_3.jpg

imagen_4.jpg

imagen_5.jpg

imagen_6.jpg

imagen_7.jpg

imagen_8.jpg

.....

imagen_121.jpg

imagen_122.jpg

imagen_123.jpg

imagen_124.jpg

turismos:

--------

imagen_1.jpg

imagen_2.jpg

imagen_3.jpg

imagen_4.jpg

imagen_5.jpg

imagen_6.jpg

imagen_7.jpg

imagen_8.jpg

.....

imagen_121.jpg

imagen_122.jpg

imagen_123.jpg

imagen_124.jpg

autocares:

----------

imagen_1.jpg

imagen_2.jpg

imagen_3.jpg

imagen_4.jpg

imagen_5.jpg

imagen_6.jpg

imagen_7.jpg

imagen_8.jpg

.....

imagen_121.jpg

imagen_122.jpg

imagen_123.jpg

imagen_124.jpg

motocicletas:

------------

imagen_1.jpg

imagen_2.jpg

imagen_3.jpg

imagen_4.jpg

imagen_5.jpg

imagen_6.jpg

imagen_7.jpg

imagen_8.jpg

.....

imagen_121.jpg

imagen_122.jpg

imagen_123.jpg

imagen_124.jpg[/b]

[/indent]

Como organizarias las imagenes para entrenar un modelo CNN.

----------------------------------------------------------

En principio, nosotros las organizariamos como sigue. Sin duda

puede haber más opciones que puedes experimentar,siempre que des la ruta adecuada

de acceso a tu modelo:ProyectoCNN.

ProyectoCNN/

└── dataset/

├── train/

│ ├── camiones/

│ │ ├── imagen_1.jpg

│ │ ├── imagen_2.jpg

│ │ ├── ...

│ │ └── imagen_124.jpg

│ ├── turismos/

│ │ ├── imagen_1.jpg

│ │ ├── imagen_2.jpg

│ │ ├── ...

│ │ └── imagen_124.jpg

│ ├── autocares/

│ │ ├── imagen_1.jpg

│ │ ├── imagen_2.jpg

│ │ ├── ...

│ │ └── imagen_124.jpg

│ └── motocicletas/

│ ├── imagen_1.jpg

│ ├── imagen_2.jpg

│ ├── ...

│ └── imagen_124.jpg

├── validation/

│ (mismo formato que 'train')

└── test/

(mismo formato que 'train')

En este ejemplo, he organizado las imágenes en tres conjuntos: entrenamiento (train), validación (validation), y prueba (test). Cada conjunto tiene subdirectorios para cada clase de vehículo (camiones, turismos, autocares, motocicletas). Esto es una práctica común al trabajar con modelos de aprendizaje profundo.

Espero que esto te ayude a estructurar tus datos para el entrenamiento de tu modelo CNN. Asegúrate de ajustar la división entre conjuntos de entrenamiento, validación y prueba según tus necesidades específicas.

**************************************************************************************************************

Los directorios "validation" y "test" son comúnmente utilizados en el entrenamiento de modelos de aprendizaje profundo, como las redes neuronales convolucionales (CNN), para evaluar el rendimiento del modelo en datos que no ha visto durante el entrenamiento. Aquí hay una breve descripción de cada uno:

Conjunto de Validación:

----------------------

Propósito: Se utiliza durante el entrenamiento del modelo para ajustar los hiperparámetros y evitar el sobreajuste (overfitting).

Composición:

---------------

Contiene datos adicionales que no se utilizan para entrenar directamente el modelo, pero se emplean para evaluar su rendimiento durante cada época (epoch) del entrenamiento.

Cómo se usa:

-----------

Después de cada época (epoch), de entrenamiento, el modelo se evalúa en el conjunto de validación. Esto permite ajustar los hiperparámetros del modelo para mejorar su rendimiento en datos que no forman parte del conjunto de entrenamiento.

Conjunto de Prueba (Test):

-------------------------

Propósito:

----------------

Se utiliza al final del entrenamiento para evaluar el rendimiento final del modelo en datos completamente nuevos que no se han visto en absoluto durante el proceso de entrenamiento.

Composición:

-----------

Contiene datos independientes que el modelo nunca ha visto ni durante el entrenamiento ni durante la validación.

Cómo se usa:

-----------

Una vez que el modelo ha sido entrenado y ajustado utilizando el conjunto de entrenamiento y de validación, se evalúa de manera final en el conjunto de prueba para obtener una estimación imparcial de su rendimiento en datos no vistos.

La separación entre conjuntos de entrenamiento, validación y prueba ayuda a garantizar que el modelo sea capaz de generalizar bien a datos no vistos y no se sobreajuste a los datos de entrenamiento específicos.

En resumen, el conjunto de validación es utilizado para ajustar los hiperparámetros y evitar el sobreajuste durante el entrenamiento, mientras que el conjunto de prueba proporciona una evaluación final del rendimiento del modelo en datos completamente nuevos y no vistos.

********************************************************************************************************************

Debes asegurarte, para no generar errores, que las rutas, en tu caso, sean exactas.

El ejercicio para generar el módelo tendría este código, que también te pongo en el editor de códigos:

----------------------------------------------------------------------------------

import tensorflow as tf

from tensorflow.keras import layers, models

from tensorflow.keras.preprocessing.image import ImageDataGenerator

# Rutas de los datos de entrenamiento, validación y prueba

train_data_dir = 'ProyectoCNN/dataset/train'

validation_data_dir = 'ProyectoCNN/dataset/validation'

test_data_dir = 'ProyectoCNN/dataset/test'

# Parámetros

batch_size = 32

img_height = 64

img_width = 64

# Crear generadores de datos para entrenamiento, validación y prueba

train_datagen = ImageDataGenerator(rescale=1./255)

validation_datagen = ImageDataGenerator(rescale=1./255)

test_datagen = ImageDataGenerator(rescale=1./255)

train_generator = train_datagen.flow_from_directory(

train_data_dir,

target_size=(img_height, img_width),

batch_size=batch_size,

class_mode='categorical') # 'categorical' ya que hay más de dos clases

validation_generator = validation_datagen.flow_from_directory(

validation_data_dir,

target_size=(img_height, img_width),

batch_size=batch_size,

class_mode='categorical')

test_generator = test_datagen.flow_from_directory(

test_data_dir,

target_size=(img_height, img_width),

batch_size=batch_size,

class_mode='categorical')

# Construir el modelo CNN

model = models.Sequential()

model.add(layers.Conv2D(32, (3, 3), activation='relu', input_shape=(img_height, img_width, 3)))

model.add(layers.MaxPooling2D((2, 2)))

model.add(layers.Conv2D(64, (3, 3), activation='relu'))

model.add(layers.MaxPooling2D((2, 2)))

model.add(layers.Conv2D(128, (3, 3), activation='relu'))

model.add(layers.MaxPooling2D((2, 2)))

model.add(layers.Flatten())

model.add(layers.Dense(128, activation='relu'))

model.add(layers.Dense(4, activation='softmax')) # 'softmax' ya que hay más de dos clases

# Compilar el modelo

model.compile(optimizer='adam',

loss='categorical_crossentropy',

metrics=['accuracy'])

# Entrenar el modelo

model.fit(train_generator, epochs=10, validation_data=validation_generator)

# Evaluar el modelo en el conjunto de prueba

test_loss, test_acc = model.evaluate(test_generator)

print(f'Precisión en el conjunto de prueba: {test_acc}')

# Guardar el modelo

model.save('modelo_cnn_proyecto.h5')

**********************************************************************************************************

**************************************************************************************************************

Bien. En mi caso. Una vez creado el modelo con esta ruta: /home/margarito/python/modelo_cnn_proyecto.h5.

Necesito entrenar una red neuronal CNN, con el modelo: modelo_cnn_proyecto.h5 Que dada la ruta de esta

imagen de un turismo en esta ruta:/home/margarito/python/coche.jpeg . Me diga si es un camion,

una motocicleta, un coche, o un autocar.ñ

-----------------------------------------------------------------------------------------------------------

Después de haber entrenado tu modelo, puedes usarlo para hacer predicciones sobre nuevas imágenes.

Aquí tienes un ejemplo de cómo cargar el modelo y realizar una predicción sobre la imagen de un turismo:

import tensorflow as tf

from tensorflow.keras.preprocessing import image

from tensorflow.keras.applications.vgg16 import preprocess_input, decode_predictions

import numpy as np

# Cargar el modelo previamente entrenado

modelo = tf.keras.models.load_model('/home/margarito/python/modelo_cnn_proyecto.h5')

# Cargar la imagen de un coche

img_path = '/home/margarito/python/coche.jpeg'

img = image.load_img(img_path, target_size=(64, 64))

img_array = image.img_to_array(img)

img_array = np.expand_dims(img_array, axis=0)

img_array = preprocess_input(img_array)

# Realizar la predicción

predictions = modelo.predict(img_array)

# Obtener las clases predichas

class_indices = {0: 'camiones', 1: 'turismos', 2: 'autocares', 3: 'motocicletas'}

predicted_class = class_indices[np.argmax(predictions)]

# Imprimir el resultado

print(f'Predicción: {predicted_class}')

------------------------------------------------------------------------------------------

Este script carga la imagen del coche, la preprocesa de manera adecuada para el modelo, realiza la predicción y luego imprime la clase predicha. Asegúrate de que la imagen esté en el formato adecuado y ajusta las rutas según sea necesario. Recuerda que el modelo fue entrenado con clases específicas ('camiones', 'turismos', 'autocares', 'motocicletas'), así que las clases predichas deben coincidir con estas categorías.

************************************************************************************

[b]El ejercicio fue realizado bajo plataforma Linux.

Concretamente:Ubuntu 20.04.6 LTS

Editado con:Sublime Text.

-------------------------

Se debe de tener en cuenta que en tu ordenador deberan estar cargadas las librerias necesarias.

En nuestro caso:

---------------

import tensorflow as tf

from tensorflow.keras import layers, models

from tensorflow.keras.preprocessing.image import ImageDataGenerator

-------------------------------------------

from tensorflow.keras.preprocessing import image

from tensorflow.keras.applications.vgg16 import preprocess_input, decode_predictions

import numpy as np

************************************************************************************

Ejecucion de los programas:

#Crear_Modelo_CN_Aula-28.py

#Ejecución:python3 Crear_Modelo_CN_Aula-28.py

--------------------------------------------------

#Util_Modelo_Creado_Aula-28.py

#Ejecutar: python3 Util_Modelo_Creado_Aula-28.py

*******************************************************************************************************

********************************************************************************************************************

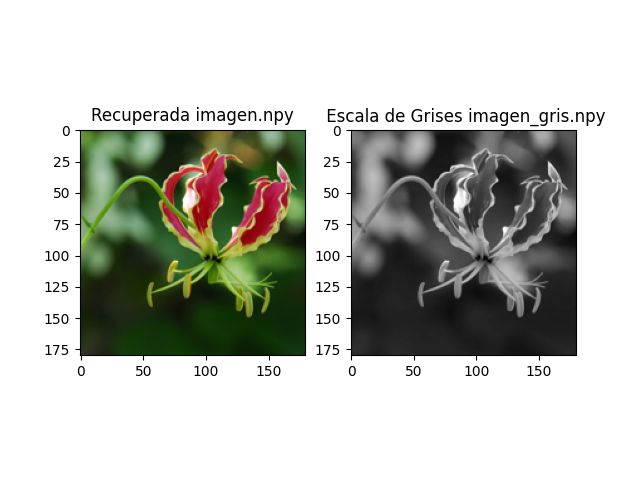

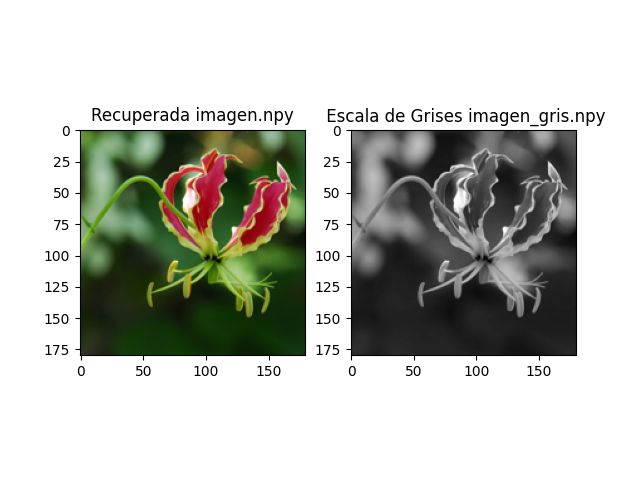

Aula-28-Trabajo_Imagenes.py

**********************************

Ejecución: python3 Aula-28-Trabajo_Imagenes.py

Utilizando los ficheros

.npy, guardamos el array original de pixels en un fichero que llamamos:

imagen.npy. Luego manipulamos la imagen a escala de grises en el fichero:

imagen_gris.npy, que tambien guardamos, y abrimos para mostrar su modificación.

El sencillo ejercicio se puede manipular y modificar parámetros para observar resultados. Se tendrá en cuenta en sustituir la ruta de los archivos a tratar, que deben estar en el mismo directorio donde se encuentra: Aula-28-Trabajo_Imagenes.py

--------------------------------------------------------------------------------------------------------------------------------------

El ejercicio consiste en cargar una imagen en color, convertirla a escala de grises y guardar la imagen en escala de grises en un archivo.

El código del ejercicio se divide esquemáticamente en dos partes principales:

Parte 1: Cargar la imagen y convertirla a un array NumPy.

Parte 2: Convertir la imagen a escala de grises y guardarla en un archivo.

En la parte 1 del código, se utiliza la función Image.open() para cargar la imagen. A continuación, se utiliza la función resize() para cambiar el tamaño de la imagen a 180x180 píxeles. Por último, se utiliza la función img_to_array() para convertir la imagen a un array NumPy.

En la parte 2 del código, se utiliza la función rgb_to_grayscale() de TensorFlow para convertir la imagen a escala de grises. A continuación, se utiliza la función convert_image_dtype() para convertir la imagen a un tipo de datos NumPy de 8 bits. Por último, se utiliza la función save() para guardar la imagen en escala de grises en un archivo.

El código convierte la imagen original a escala de grises de forma correcta. La imagen en escala de grises conserva la información principal de la imagen original, pero pierde los detalles de color.

---------------------------------------------------------------------------------------------------------------------

Exponemos aquí un ejemplo de redes neuronales convolucionales

CNN,

basadas en transferencia de estilo. Partiendo de una imagen original, y otra imagen que dará

la forma del estilo(en nuestro caso, un cuadro de Picaso), construiremos otra, basada en las dos anteriores.

El programa que citamos aquí está basado en en un ejemplo

del

blog RUBENJROMO

https://rubenjromo.com/

Modificados algunos parámetros.

Editado y ejecutado en GoogleColab.

Archivos de muestra, alojados en DRIVE.

https://drive.google.com/

Modelo vgg19-dcbb9e9d.pth bajado de:

"https://download.pytorch.org/models/vgg19-dcbb9e9d.pth

*****************************************************************************

Las redes neuronales convolucionales

(CNN) y la

transferencia de estilo son conceptos distintos en el campo del aprendizaje profundo, pero a veces se combinan para lograr resultados interesantes en el procesamiento de imágenes. Aquí hay una breve descripción de cada uno:

Redes Neuronales Convolucionales (CNN):

Las CNN son un tipo de arquitectura de red neuronal diseñada específicamente para procesar datos de rejilla, como imágenes. Utilizan capas de convolución para extraer características relevantes de la imagen de entrada.

La convolución implica el uso de filtros o kernels que se deslizan sobre la imagen para realizar operaciones locales, lo que permite detectar patrones específicos, como bordes, texturas o formas.

Están compuestas por capas convolucionales, capas de activación (como la

ReLU), capas de agrupación (pooling) y capas completamente conectadas.

Transferencia de Estilo:

La transferencia de estilo es una técnica que utiliza redes neuronales para combinar el contenido de una imagen con el estilo de otra imagen de manera creativa.

Se basa en la idea de separar el contenido y el estilo de una imagen. La información de contenido se extrae de una imagen de referencia, mientras que el estilo se toma de otra imagen.

La red neuronal intenta generar una nueva imagen que conserve el contenido de una imagen de entrada pero adopte el estilo de otra imagen de referencia.

Cuando se combinan estas dos ideas, se puede aplicar la transferencia de estilo utilizando una CNN. La idea es utilizar una red preentrenada, como

VGG16 o VGG19, para extraer tanto el contenido como el estilo de las imágenes. Luego, se optimiza una nueva imagen para que coincida con el contenido de una imagen de entrada y el estilo de otra imagen de referencia. Este proceso permite crear imágenes que fusionan el contenido de una imagen con el estilo artístico de otra.

En resumen, las CNN son arquitecturas de redes neuronales diseñadas para el procesamiento de imágenes, mientras que la transferencia de estilo es una técnica que utiliza redes neuronales para combinar el contenido y el estilo de diferentes imágenes. Al aplicar la transferencia de estilo con una CNN, se pueden lograr resultados visualmente atractivos y creativos.