Sencilla red neuronal. Repaso.

Python

Publicado el 11 de Noviembre del 2023 por Hilario (145 códigos)

537 visualizaciones desde el 11 de Noviembre del 2023

********************************************************************************************************************

Aula_18_B.py

******************************************************************************************************************

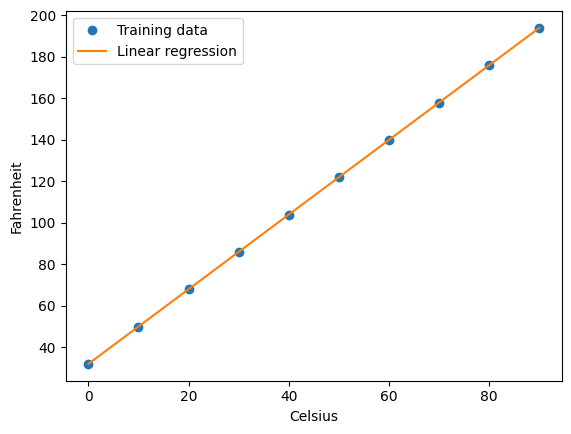

Se trata de una sencilla red neuronal, ya resuelta en otro ejercicio,

utilizando la librería keras. Ahora lo planteamos de nuevo, utilizando

solamente las librerias numpy y matplotlib.

Se trataba de una red neuronal con este esquema:

input_size = 1

hidden_layer1_size = 8

hidden_layer2_size = 8

output_size = 1

Una neurona de entrada, con dos capas ocultas intermedias de 8 neuronas

cada una, y 1 neurona de salida.

Los datos generales y sencillos de la idea son los siguientes:

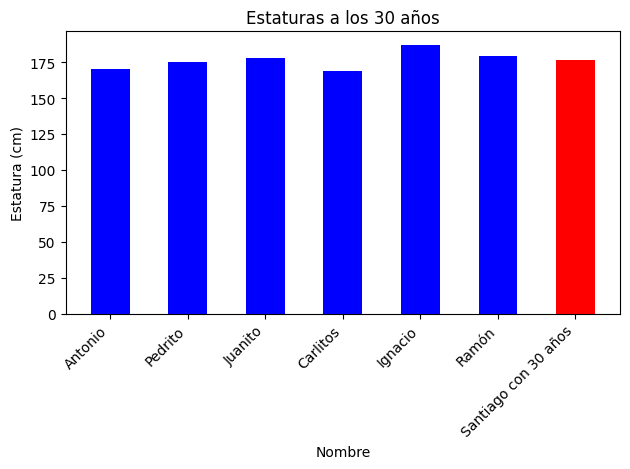

Se trata de cinco hermanos que a los 30 años median lo siguiente:

Antonio 1,70 cm. Pedrito 1,75. Juanito 1,78 . Carlitos 1,69. Ignacio 1,87.

Ramón 1,79.

Hace 6 meses ha nacido Santiaguito.

Cuales son las previsiones de estatura

cuando también tenga 30 años. Haremos graficas de salida de columnas.

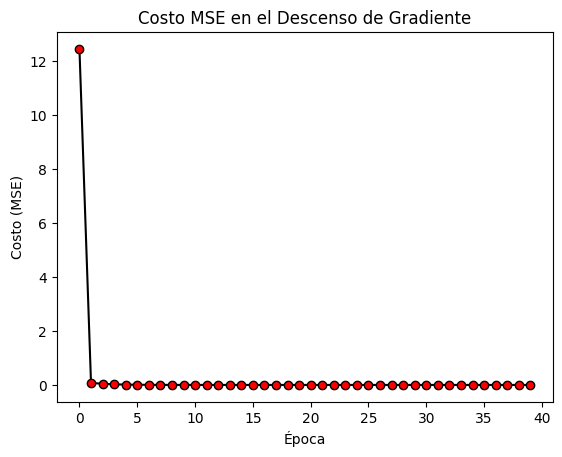

También haremos gráficas de costos MSE, con salida imprimida por consola

de los valores de los mismos por cada iteración.

También se imprime en la salida la previsión que hace la red neuronal

de la estatura futura

Los hiperparámetros que adoptamos, son los siguientes:

learning_rate = 0.01

epochs = 40

Se puede jugar con los mismos con el fin de afinar los

resultados.

*************************************************************

Este ejercicio ha sido realizado en una plataforma Linux.

Ubuntu 20.04.6 LTS.

Se utiliza el editor Sublime text

*********************************************************

Ejecucion bajo consola linux con el comando:

python3 Aula_18_B.py