Actualizado el 23 de Julio del 2017 (Publicado el 17 de Julio del 2017)

1.036 visualizaciones desde el 17 de Julio del 2017

704,6 KB

13 paginas

Creado hace 20a (31/01/2005)

LinuxFocus article number 345

http://linuxfocus.org

El Linux en la Ciencia ó Cómo se ha

desarrollado una aplicación de Redes

Neuronales

Resumen:

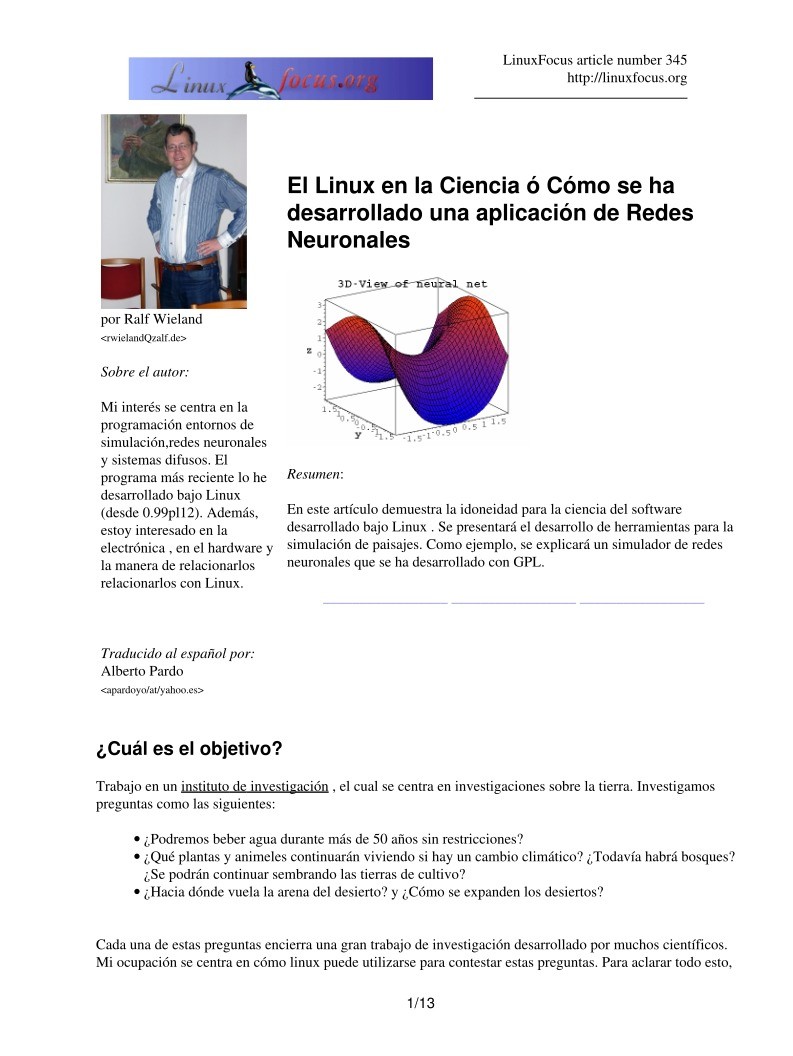

En este artículo demuestra la idoneidad para la ciencia del software

desarrollado bajo Linux . Se presentará el desarrollo de herramientas para la

simulación de paisajes. Como ejemplo, se explicará un simulador de redes

neuronales que se ha desarrollado con GPL.

_________________ _________________ _________________

por Ralf Wieland

<rwielandQzalf.de>

Sobre el autor:

Mi interés se centra en la

programación entornos de

simulación,redes neuronales

y sistemas difusos. El

programa más reciente lo he

desarrollado bajo Linux

(desde 0.99pl12). Además,

estoy interesado en la

electrónica , en el hardware y

la manera de relacionarlos

relacionarlos con Linux.

Traducido al español por:

Alberto Pardo

<apardoyo/at/yahoo.es>

¿Cuál es el objetivo?

Trabajo en un instituto de investigación , el cual se centra en investigaciones sobre la tierra. Investigamos

preguntas como las siguientes:

•

•

•

¿Podremos beber agua durante más de 50 años sin restricciones?

¿Qué plantas y animeles continuarán viviendo si hay un cambio climático? ¿Todavía habrá bosques?

¿Se podrán continuar sembrando las tierras de cultivo?

¿Hacia dónde vuela la arena del desierto? y ¿Cómo se expanden los desiertos?

Cada una de estas preguntas encierra una gran trabajo de investigación desarrollado por muchos científicos.

Mi ocupación se centra en cómo linux puede utilizarse para contestar estas preguntas. Para aclarar todo esto,

1/13

�tenemos que examinar la manera con la que se realizan las investigaciones y los análisis. Este tipo de retos tan

desmoralizadores, como los mencionados anteriormente, consisten analizar muchos subproblemas. Si uno

quiere clarificar si el agua permanece potable, se necesita obtener los datos del agua. Las fuentes de los datos

son diversas. Sirva como ejemplo que la agricultura constribuye considerablemente en la polución del

agua.¿Pero con que grado lo hace actualmente? y ¿Con qué intervalo de tiempo se contamina el agua?

Para contestar este tipo de preguntas, se ha de considerar cada dato aportado. Es un proceso elaborado y por

desgracia, acompañado de errores serios. Quién sabe a ciencia cierta la contaminación que aporta el aire,

através de los desechos industriales o de la agricultura. Los datos están asociados con las precipitaciones, su

transporte y la evaporación. Además , estos factores están influenciados por los cambios climáticos. Para

poder investigar este proceso, la simulación por ordenador es un requisito indispensable . Como paso previo a

la simulación, se han de determinar un número de restricciones, parámetros y funciones. Las funciones y los

parámetros se extraen de los test de laboratorio, test de campo y observaciones reales. Nos indican la

absorción del fertilizante por las plantas, el proceso de degradación del suelo, etc.

La simulación se basa en dar por supuesto un escenario base y se ejecuta mediante Simulación Monte Carlo.

Para hacer esto se varía estocasticamente los datos y se repite la simulación con diferentes condiciones

iniciales. El resultado es una colección de datos posibles, pero con diferentes probabilidades. Este conjunto de

datos han de ser analizados y editados para servir como base para la toma de decisiones. El logro del modelo

regional es la preparación para cambios potenciales y desarrollar hoy técnicas para un uso sostenible de la

tierra.

No podemos predecir el futuro, pero estamos preparandonos para él.

Para ser más precisos, tenemos que reconocer que el trabajo de modelación consiste en dos partes.En la

primera, los modelos se han de adaptar, se necesita un conjunto de datos para analizar y se deben escribir

artículos. La segunda parte consiste en el desarrollo de un software optimizado para hacer la investigación.

El trabajo detallado diario con Linux

La misión diaria, consiste en el análisis de datos,quejandonos de los datos de medidas incorrectos,

transformando los datos a los diversos formatos, escribir informes,etc..., beneficiandonos de Linux. Si aún

alguien cree que con Excel puede puede hacer todo, es que no ha probado la combinación de Perl,

Emacs,octave [www.octave.org], R [www.r−project.org] etc. Juntos han demostrando ser un duro adversario

en la batalla con los datos.Perl es muy versatil,no esta limitado por la conversión de datos y requiere basesde

datos (MySQL), ejecuta cálculos, etc., todo esto de manera rápida y repetidamente. Especificamente, esto

último es muy portante, ya que el trabajo manual lleva a manejar los datos de manera erronea. Esto es raro si

se utlizan scripts ya comprobados. Escribir artículos con LaTeX, permite obtener un resultado convincente y

de gran cálidad gráfica. Linux posee herramientas con las que hacen actractivo el trabajo a los científicos. No

queremos ocultar una desventaja: el proceso de aprendizaje de estas herramientas es largo. No todo se puede

hacer intuitivamente y no todo el mundo es un "FREAK" de la programación.

El Siguiente Paso − El Desarrollo de las Herraminetas

¿Por qué se ha de desarrollar uno mismo las herramientas?, ¿No esta todo disponible? Existen herramientas de

alto rendiemiento para la simulación, como Matlab [www.mathworks.com]. Existen herramientas para

procesar datos geográficos del Sistema de Información Geografica (GIS) como ARCGIS

[www.esri.com/software/arcgis] o sotware libre Grass [grass.itc.it] . Y también hay programas para estadística

. Así, ¿Por qué continuar desarrollando?

El problema no está en la cálidad de los componentes, sino en su interacción en el sistema. En la simulación,

las subtareas las realizan diferentes programas que se comunican de una manera , que se le podría llamar

pesada, atraves de interfaces creados por el propio usuario. Este hecho queda agravado por el hecho que los

datos disponibles en grandes cantidades (datos espaciales) contienen un gran porcentaje de errores. Las

simulaciones básicas se han de ajustar para esta carácteristica. Un algoritmo ha de conseguir resultados

2/13

�validos, y si los datos entrados no están totalmente emparejados, ha de indicarlo mediante un mensaje de aviso

. En el procesado de grandes cantidades de datos ,es normal tener matrices con más de un millon de elementos

y por lo tanto, se requieren algoritmos rápidos. Sólo se obtienen algoritmos robustos y rápidos, si se los

desarrolla uno mismo.

La principal desventaja de los sistemas comerciales es que su código fuente es secreto . ¿Cuantos científicos

desarrollan e intercambian modelos si las fuentes no son libres? Con esta conclusión decidí desarrollar una

Herramienta de análisis espacial y de modelación ("Spatial Analysis and Modeling Tool" (SAMT)) como

software de código abierto.

. Es una herramienta de simulación que incorpora un gestor para datos espaciales, interfaces con la base de

datos MySQL y a GIS. Contiene las funciones elementales para gestionar datos basados en "raster" y tiene

capacidad para manipularlos (homogeneizar, distancias, interpolar, etc. ) y capaz de generar presentaciones de

los datos en dos o tres dimensiones.

Nota: Los datos del tipo "raster" se basan en dividir un mapa en una rejilla de cuadrados pequeños. La

información se almacena en varias capas de datos raster.Un modelo accede a la informació de las

capas.Además de accededer a la información cada vez más profunda, también es fundamental la información

envolvente del mismo nivel. Esto es la base para el módelado de flujos laterales, como ocure en la erosión del

suelo, causado por el aire y el viento.

SAMT genera la estructura en la cual las herraminetas − como interpretador difuso (muy rápida) y la

herramiente de red neuronal (nnqt) − pueden adaptarse. Los modelos difusos sirven para integrar sistemas

expertos en la simulación. Un sistema experto con frecuencia describe un proceso o lo controla,

principalmente si no hay módelo matemático. Las redes neuronales tienen procesos los cuales nos permiten

derivar correlaciones funcionales de los datos de medida. A continuación introduciremos el desarrollo de una

herramienta de redes neuronales.

¿Qué es una red neuronal?

Una red neuronal consiste en varios estratos o capas. El primer estrato se cargará con los datos iniciales a

probar,en números de punto flotante. La capa entre la entrada y la salida no es visible desde fuera, por lo que

se le llama 'estrato oculto'. En algunos casos se pueden tener varios estrato ocultos. El estrato de salida, por

ejemplo, únicamente tiene un elemento. Este tipo de arquitectura se usa para construir funciones con varias

entradas y una salida. Los estratos ocultos son necesarios para analizar el comportamiento no lineal, por

ejemplo el de la función x^2−y^2. ¿Cómo sabe la red neuronal cual es la función buscada? Inicialmente,la red

no conoce la función. Los conectores (pesos) entre los elementos (nodos) son atribuidos con valores

estocasticos. Durante el proceso de entrenamiento, el algoritmo que esta aprendiendo trata de cambiar los

pesos de manera que el error cuadrático medio entre el ordenador y el valor predeterminado de salida sea

mínimo. Hay una variedad de algoritmos que ya se encargan de ello y no será necesario elaborar ninguno en

este artículo. Tres algoritmos fuerón implementados en nnqt. El proceso de 'Enseñanza supervisada consiste

en diseñar la salida dependiendo de la entrada.

3/13

�La red está entrenda para detectar si ha alcanzado un error mínimo con los datos de aprendizaje tanto como

con los datos de control (es aconsejable separar los datos previos del entrenamiento de los usados como datos

para verificar la función de aprendizaje). Los pesos determinan la conducta de la red y son almacenados para

este proposito. ¿Qué se espera conseguir con esta red? Aparte de las aplicaciones para la ciencia, tambíen hay

aplicaciones más o menos serias. Hay intentos de predecir las tendencias de los mercados financieros. No he

conseguido nada en este campo, pero quizas algu

Crear cuenta

Crear cuenta

Comentarios de: El Linux en la Ciencia ó Cómo se ha desarrollado una aplicación de Redes Neuronales (0)

No hay comentarios