Descenso Gradiente tipo Nesterov

Python

Publicado el 18 de Octubre del 2023 por Hilario (145 códigos)

409 visualizaciones desde el 18 de Octubre del 2023

Descen_Grad_Nesterov_Aula_B_28_18_OCT_github.py

----------------------------------------------------------------------------------------------------

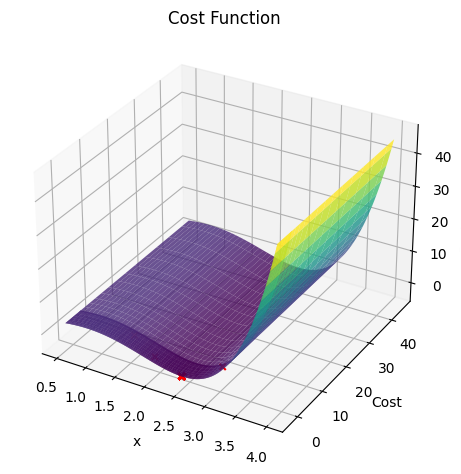

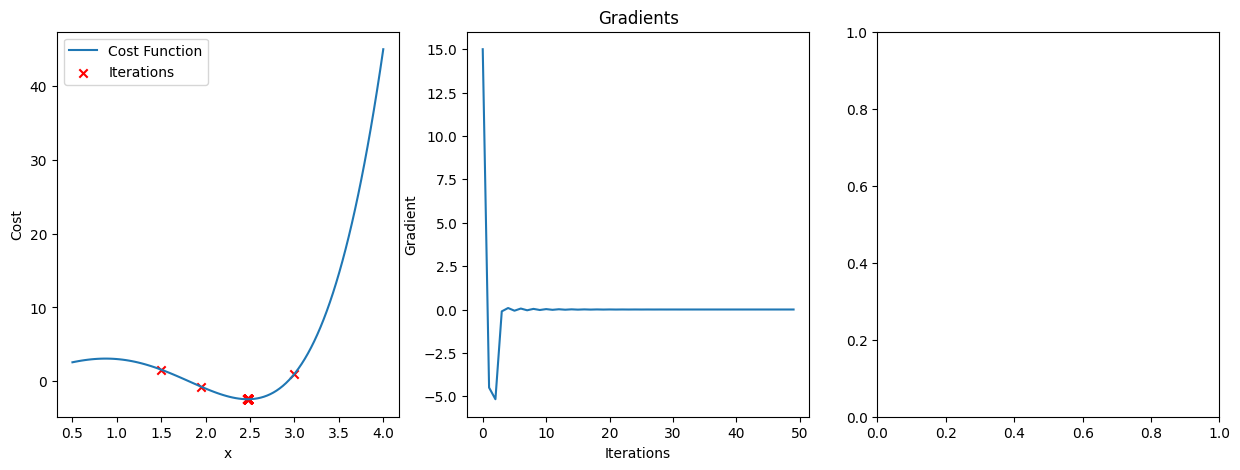

El descenso de gradiente tipo Nesterov, también conocido como el "descenso de gradiente acelerado de Nesterov" o "NAG" por sus siglas en inglés (Nesterov Accelerated Gradient Descent), es una variante del algoritmo de optimización de descenso de gradiente utilizado en el entrenamiento de redes neuronales y en la optimización de funciones en el aprendizaje automático.

Fue propuesto por Yurii Nesterov en 1983 y es una mejora con respecto al descenso de gradiente estándar, especialmente en términos de velocidad de convergencia. El descenso de gradiente Nesterov se diferencia del descenso de gradiente tradicional en cómo se actualizan los parámetros del modelo.

En el descenso de gradiente Nesterov, en lugar de calcular el gradiente de la función de costo en la posición actual de los parámetros, se calcula el gradiente en una posición ligeramente adelantada de los parámetros. Luego, se utiliza ese gradiente para realizar la actualización de los parámetros. Esto tiene el efecto de "mirar hacia adelante" antes de dar el paso de actualización, lo que puede ayudar a reducir la oscilación y mejorar la velocidad de convergencia.

La fórmula para la actualización de los parámetros en el descenso de gradiente tipo Nesterov es la siguiente:

v = γ * v - η * ∇J(θ - γ * v)

θ = θ + v

Donde:

θ son los parámetros del modelo.

∇J(θ - γ * v) es el gradiente de la función de costo evaluado en la posición adelantada de los parámetros.

v es una especie de "momentum" que acumula la velocidad de los pasos anteriores.

η es la tasa de aprendizaje.

γ es un hiperparámetro que controla la influencia del momentum en la actualización.

En resumen, el descenso de gradiente tipo Nesterov es una técnica de optimización que tiene la ventaja de converger más rápidamente que el descenso de gradiente estándar, lo que lo hace especialmente útil en el entrenamiento de redes neuronales profundas y otros problemas de optimización en el aprendizaje automático.