Suavizado de imagen en archivos de vídeo por 'Filtrado bilateral', (aplicación en línea de comandos)

Python

(2)

(2)Actualizado el 23 de Mayo del 2024 por Antonio (77 códigos) (Publicado el 20 de Marzo del 2023)

7.840 visualizaciones desde el 20 de Marzo del 2023

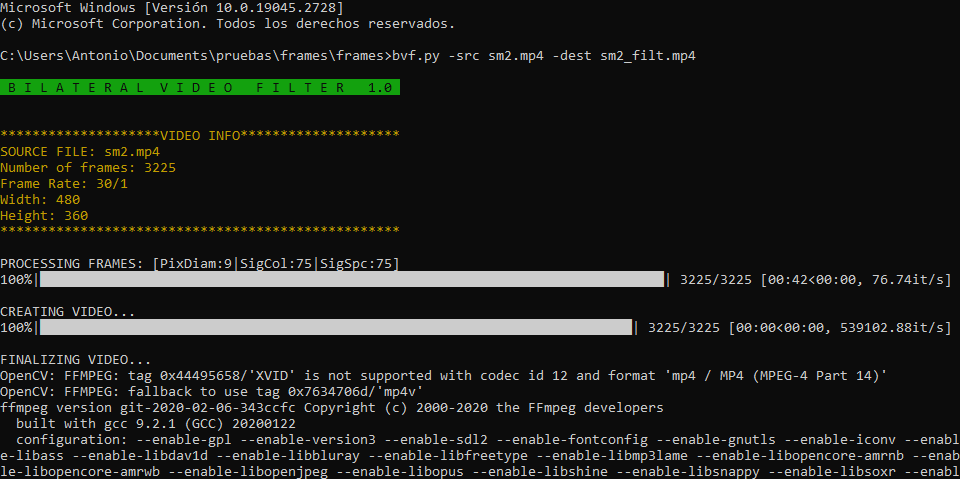

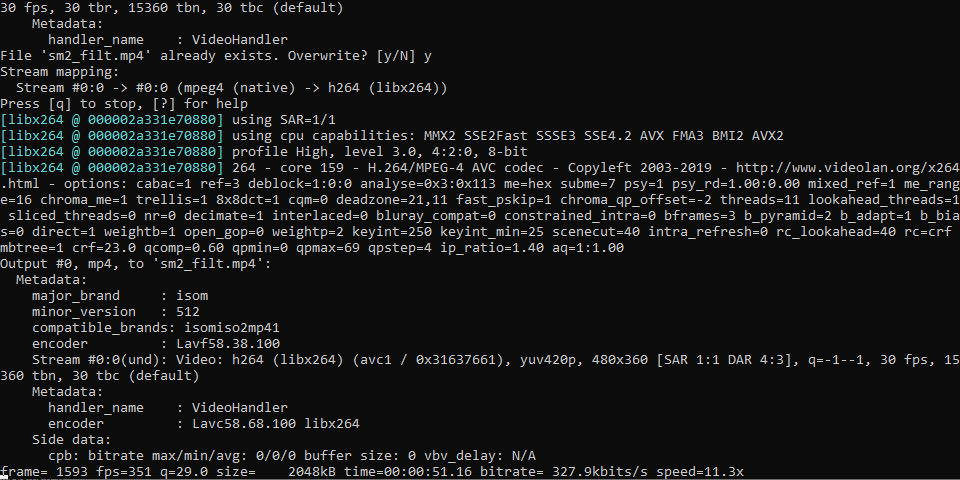

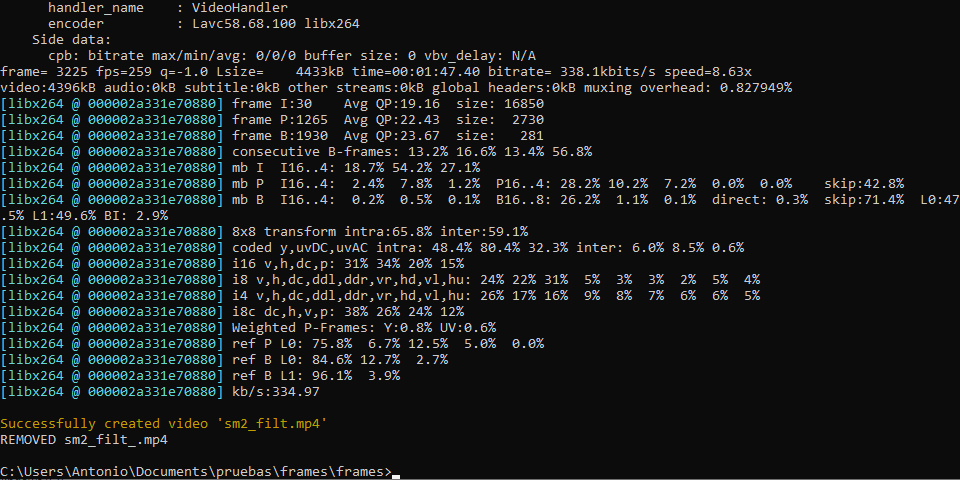

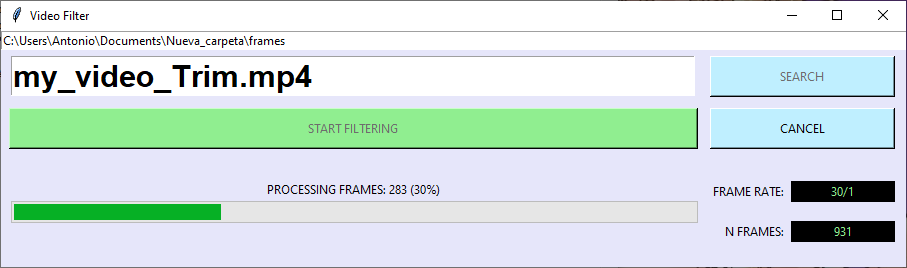

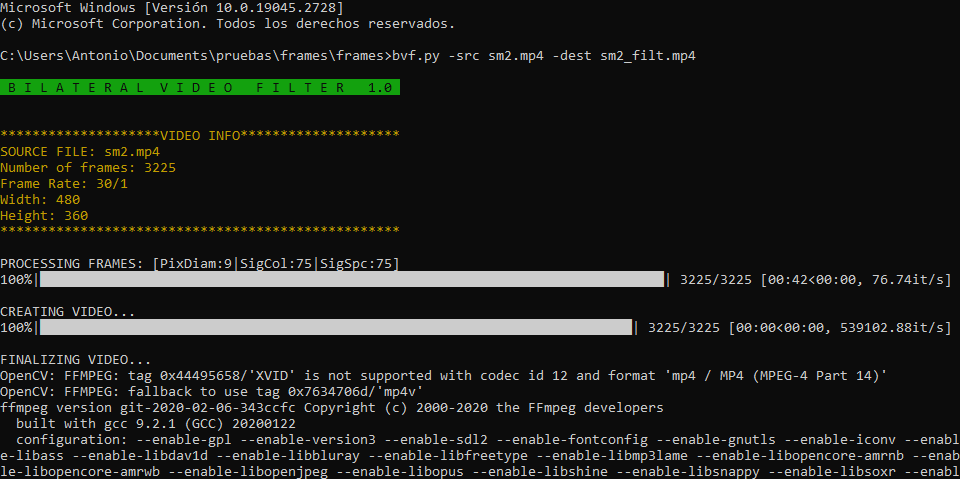

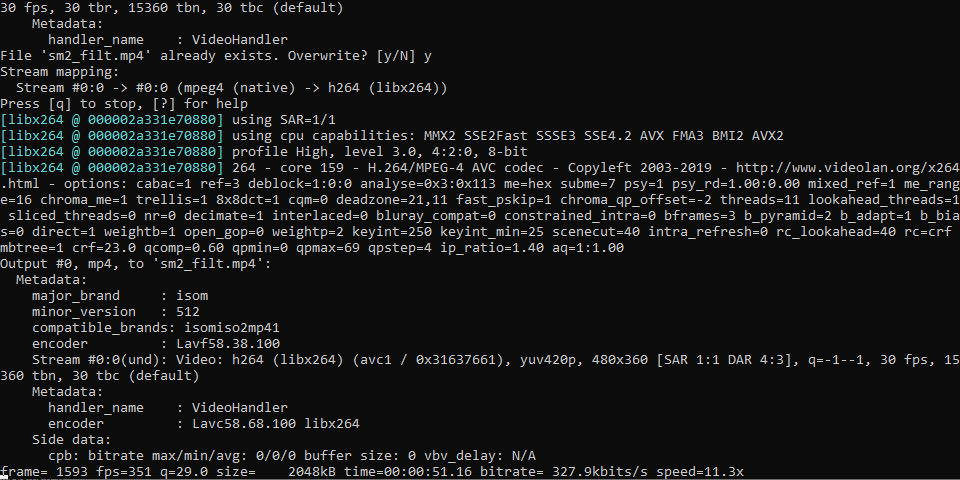

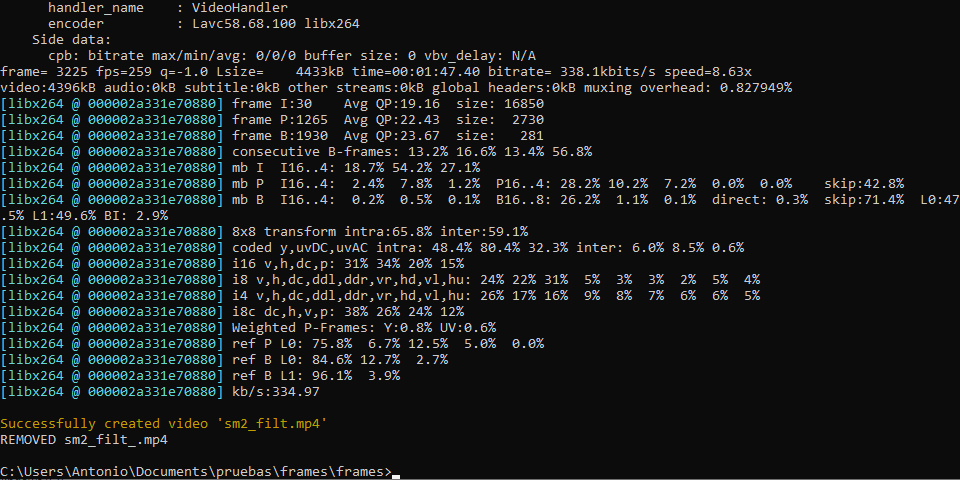

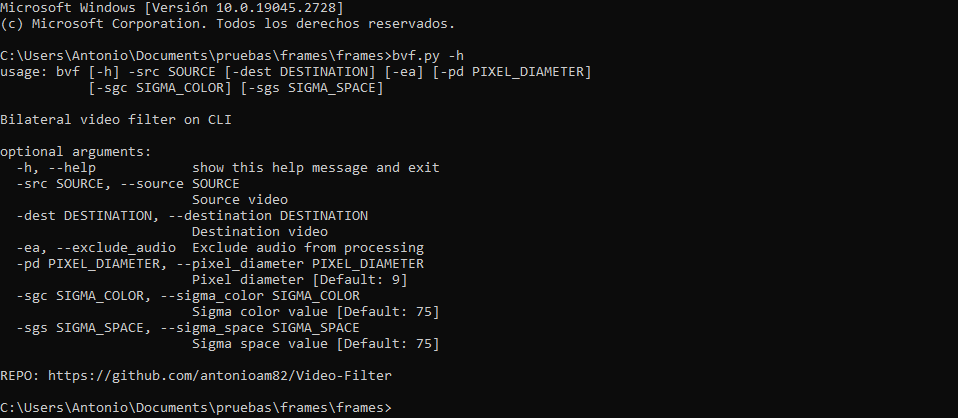

Programa para realizar filtrado de imagen en archivos de vídeo (preferiblemente de corta duración) utilizando el algoritmo de 'filtrado bilateral' pudiendo especificar los valores sigma de espacio y color y el diámetro del vecindario para cada pixel. Los vídeos filtrados se generan, por defecto, conservando su sonido, aunque se pueden generar sin este introduciendo el argumento '-ae'/'--exclude_audio'.

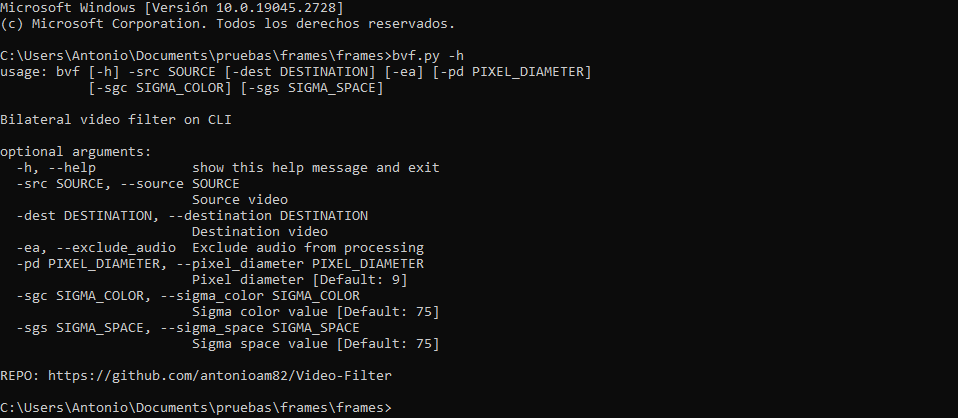

ARGUMENTOS:

-src/--source: Nombre del vídeo original (OBLIGATORIO)

-dest/--destination: Nombre del video a generar ('NewFilteredVid.mp4' por defecto)

-sgc/--sigma_color: Valor sigma para espacio de color (75 por defecto)

-sgs/--sigma_space: Valor sigma espacial (75 por defecto)

-pd/--pixel_diameter: Diámetro de la vecindad de píxeles (9 por defecto)

-ae/--exclude_audio: Excluir audio y generar video sin sonido (OPCIONAL)

PARA CUALQUIER DUDA U OBSERVACIÓN UTILIZEN LA SECCIÓN DE COMENTARIOS

ARGUMENTOS:

-src/--source: Nombre del vídeo original (OBLIGATORIO)

-dest/--destination: Nombre del video a generar ('NewFilteredVid.mp4' por defecto)

-sgc/--sigma_color: Valor sigma para espacio de color (75 por defecto)

-sgs/--sigma_space: Valor sigma espacial (75 por defecto)

-pd/--pixel_diameter: Diámetro de la vecindad de píxeles (9 por defecto)

-ae/--exclude_audio: Excluir audio y generar video sin sonido (OPCIONAL)

PARA CUALQUIER DUDA U OBSERVACIÓN UTILIZEN LA SECCIÓN DE COMENTARIOS