--------------------------------------------------------------------------------------------------------------

**********************************************************************************************

Fourier_Aula_28_Junio_24.py

**********************************

Antes de empezar,queridos alunmnos, vamos a explicar, para entendernos lo mejor posible, que es una serie de

Fourier:

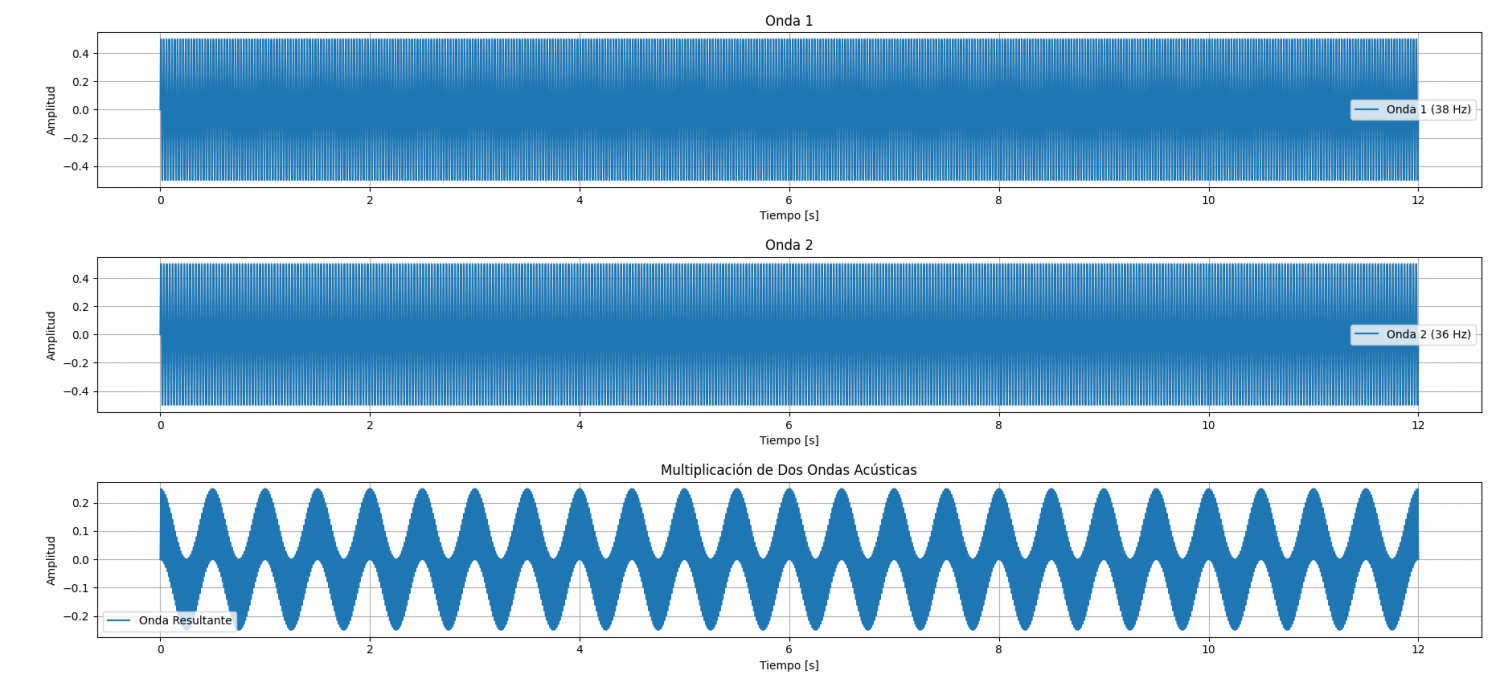

Imagina que tienes una onda compuesta por varias frecuencias mezcladas, como la melodía de una canción. Las series de Fourier son como una herramienta matemática que te permite descomponer esa onda compleja en sus partes más simples: ondas sinusoidales (ondas de seno y coseno) de diferentes frecuencias.

Es como si tuvieras un prisma que descompone la luz blanca en los colores del arcoíris. Las series de Fourier hacen lo mismo con las ondas: las descomponen en sus "colores" individuales, que son las ondas sinusoidales de diferentes frecuencias.

En resumen:

**************

¿Qué son? Las series de Fourier: son una forma de representar funciones periódicas (que se repiten a lo largo del tiempo) como una suma de ondas sinusoidales más simples.

Y te preguntarás ¿Para qué sirven? Sirven para analizar y comprender mejor las funciones periódicas, como las ondas de sonido, las señales de audio o las vibraciones.

¿Cómo funcionan? Descomponen la función periódica en una suma infinita de ondas sinusoidales de diferentes frecuencias. Cada onda sinusoidal tiene una amplitud y una frecuencia específica, y juntas reconstruyen la función original.

Un ejemplo sencillo:

*************************

Imagina una onda triangular, como la de los dientes de una sierra. Las series de Fourier la descompondrían en una suma de ondas sinusoidales, una con la frecuencia fundamental de la onda triangular (la frecuencia más baja), y otras con frecuencias que son múltiplos de la fundamental (2 veces, 3 veces, 4 veces...). Cada onda sinusoidal tendría una amplitud específica, y juntas recrearían la forma de la onda triangular original.

Aplicaciones:

*****************

Las series de Fourier tienen muchas aplicaciones en diversos campos, como:

*Procesamiento de señales:

*******************************

Se utilizan para analizar y modificar señales de audio, video e imágenes.

*Comunicaciones:

*******************

Se utilizan para transmitir señales de forma eficiente a través de canales de comunicación.

*Física:

*******

Se utilizan para modelar fenómenos como la vibración, la onda y la transferencia de calor.

*Matemáticas:

***************

Se utilizan para estudiar la convergencia de series infinitas y la teoría de las funciones.

En resumen, las series de Fourier son una herramienta matemática poderosa para analizar y comprender funciones periódicas. Son esenciales en muchos campos, desde la ingeniería hasta la física y la música.

+++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++

EJERCICIO PROPUESTO.

-----------------------------------

El ejercicio propuesto lo llamaremos:

Fourier_Aula_28_Junio_24.py.

A continuación os hago un pequeño resumen del mismo. No obstante, en la próxima clase podremos solucionar las dudas surgidas. El ejercicio, como véis, esta desarrollado en python.

Resumen del ejercicio:

Objetivo:

********

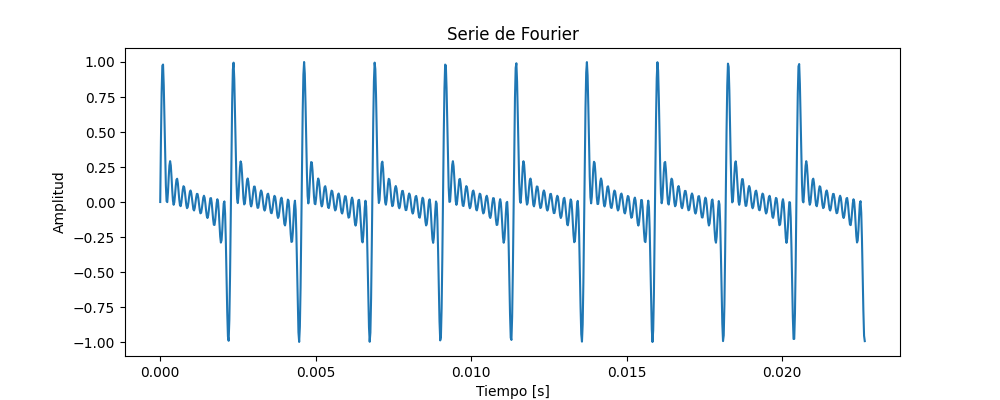

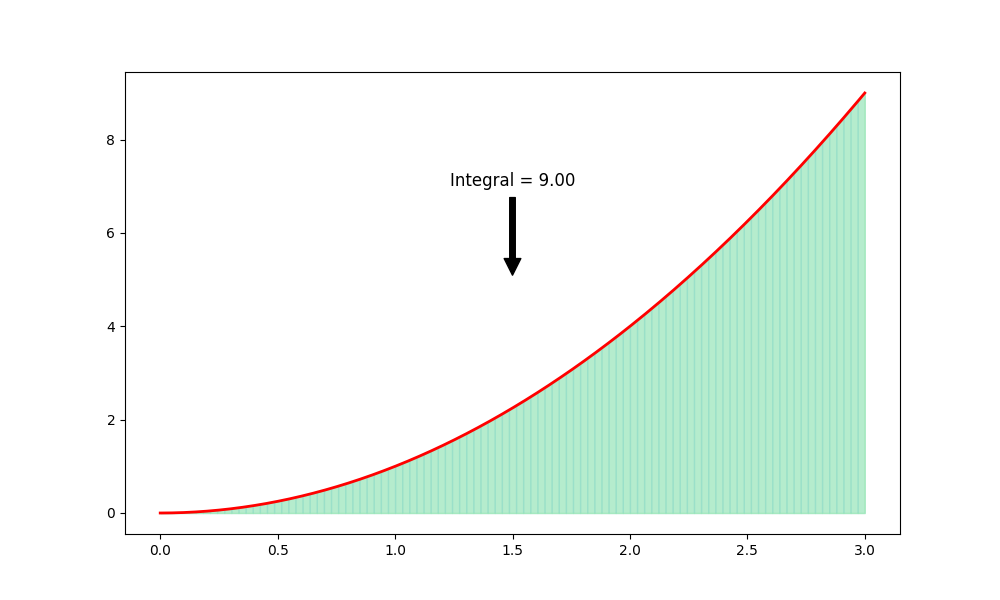

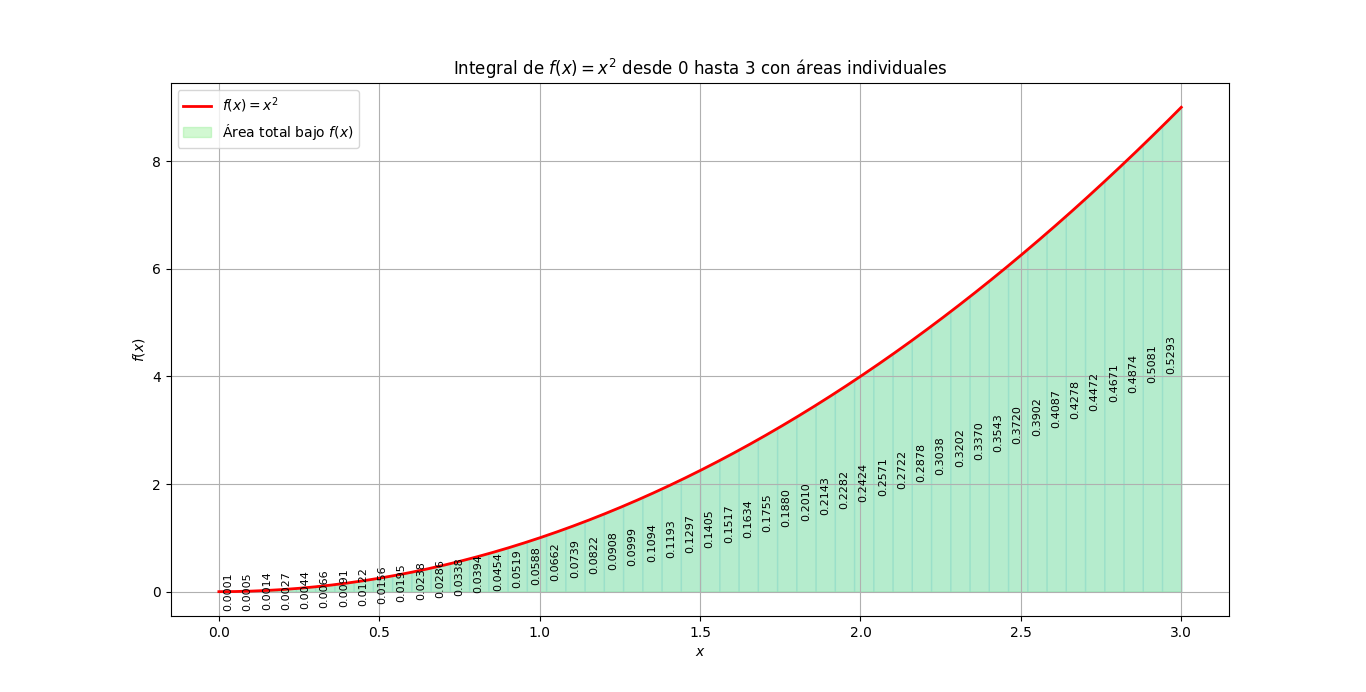

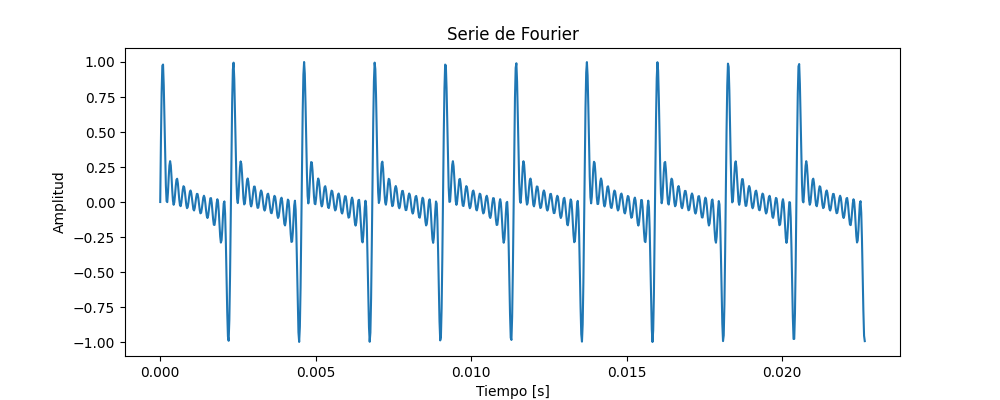

Este código en Python genera una onda sonora compuesta por la suma de armónicos de una frecuencia base, la visualiza y la guarda como un archivo de audio tipo .wav.

Explicación paso a paso:

---------------------------------

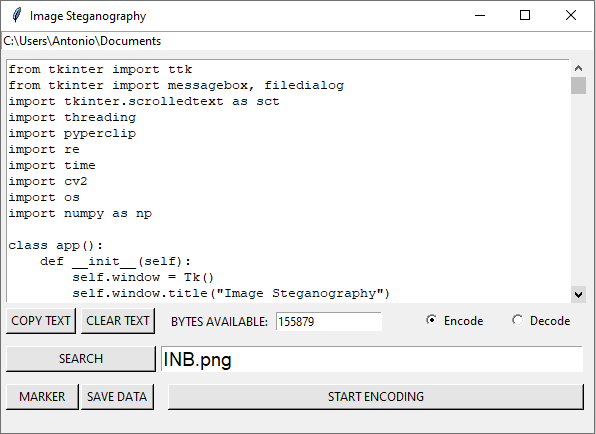

Importación de librerías:

numpy: Para realizar operaciones matemáticas con arrays.

matplotlib.pyplot: Para crear gráficos.

IPython.display.Audio: Para reproducir audio en el notebook (opcional).

scipy.io.wavfile: Para guardar la señal como un archivo de audio .wav.

pydub (opcional): Para reproducir el archivo de audio guardado (requiere instalación).

Definición de parámetros:

frecuencia_base: Frecuencia base de la onda (en Hz, por ejemplo, 440 Hz para la nota A4).

num_armonicos: Número de armónicos a sumar (por ejemplo, 10).

duracion: Duración total de la señal en segundos (por ejemplo, 4 segundos).

frecuencia_muestreo: Frecuencia de muestreo en Hz (determina la calidad del audio, 44100 Hz es común).

Creación del vector de tiempo:

t: Un array de numpy que contiene valores de tiempo desde 0 hasta duracion con frecuencia_muestreo muestras por segundo.

Inicialización de la señal:

señal: Un array de numpy inicializado con ceros del mismo tamaño que t.

Sumar armónicos:

Se realiza un bucle for desde 1 hasta num_armonicos.

Dentro del bucle, se calcula la frecuencia de cada armónico (frecuencia_n).

Se suma a la señal una onda sinusoidal con la frecuencia frecuencia_n y amplitud 1.

Normalizar la señal:

Se divide la señal por su valor máximo absoluto para que la amplitud esté entre -1 y 1.

Graficar la señal:

Se crea una figura de matplotlib.

Se grafica un segmento de la señal (t[:1000]) vs su amplitud (senal[:1000]).

Se añade un título, etiquetas de eje y se muestra el gráfico.

Reproducir el audio en el notebook (opcional):

Se crea un objeto Audio de IPython con la señal y la frecuencia de muestreo.

Se reproduce el sonido utilizando el objeto Audio.

Guardar la señal como un archivo de audio .wav:

Se utiliza la función write de scipy.io.wavfile para guardar la señal multiplicada por 32767 (para valores de audio de 16 bits) como un archivo .wav llamado serie_fourier.wav.

Reproducir el archivo de audio guardado (esto lo hacemos opcional, requiere pydub):

También podemos ejecutar el archivo una vez guardado.

Se importa AudioSegment y play de pydub.

Se carga el archivo de audio como un objeto AudioSegment.

Se reproduce el audio utilizando la función play.

En resumen, este código genera una onda sonora rica en armónicos a partir de una frecuencia base, la visualiza y la guarda en un formato de audio estándar (.wav) para que pueda ser escuchada.

*************************************************************************

Ejercicio realizado bajo linux.

Con Ubuntu 20.04.6 LTS.

Editado con Sublime text.

Ejecutado bajo consola con el sieguiente comando:

python3 Fourier_Aula_28_Junio_24.py

-------------------------------------------------------------------------

Para el correcto funcionamiento del ejercicio, deberemos de tener instalado en nuestro

sistema las siguientes librerías:

import numpy as np

import matplotlib.pyplot as plt

from IPython.display import Audio

También deberemos de tener instalados estos módulos,

instalańdolos bajo consola de linux, con los siguientes comandos:

sudo apt-get install ffmpeg

pip install pydub

----------------------------------------------------------

(1)

(1)